หายนะข้อมูล? เมื่อ ChatGPT และ Google เริ่มอ้างอิง Grokipedia ของ Elon Musk

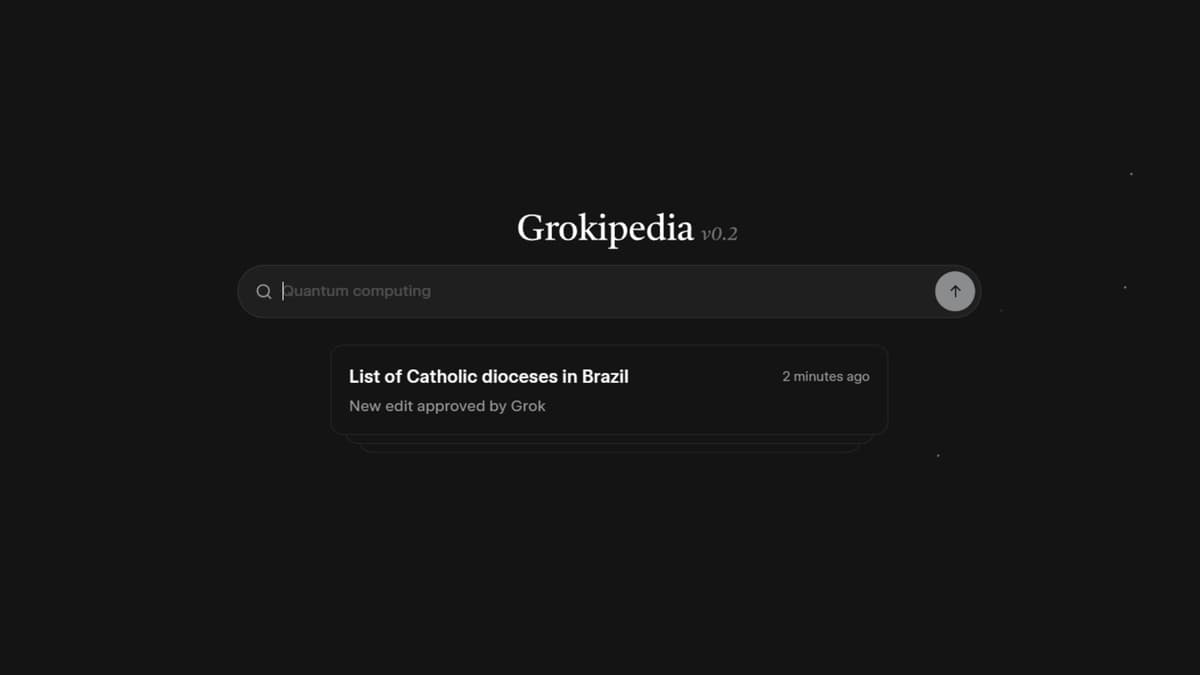

ChatGPT, Google Gemini และ AI เจ้าดังเริ่มดึงข้อมูลจาก Grokipedia สารานุกรม AI ของ Elon Musk มาตอบคำถามผู้ใช้ แม้สัดส่วนยังน้อยเมื่อเทียบกับ Wikipedia แต่กราฟพุ่งขึ้นเรื่อยๆ สร้างความกังวลเรื่องความถูกต้อง เพราะ Grokipedia ขึ้นชื่อเรื่องข้อมูลบิดเบือนและขาดการตรวจสอบจากมนุษย์

วงการข้อมูลข่าวสารเริ่มสั่นคลอน เมื่อมีการค้นพบว่า AI แชตบอตเจ้าตลาดอย่าง ChatGPT ไม่ได้ดึงข้อมูลจากแหล่งที่น่าเชื่อถือเท่านั้น แต่เริ่มหันไปอ้างอิงข้อมูลจาก Grokipedia สารานุกรมเวอร์ชัน AI ของ Elon Musk มากขึ้นเรื่อยๆ และไม่ใช่แค่ OpenAI เจ้าเดียว แต่ Google Gemini, Microsoft Copilot และ Perplexity ก็เริ่มมีพฤติกรรมเดียวกัน ข้อมูลจาก Ahrefs ระบุว่าแม้ตัวเลขการอ้างอิงจะยังห่างชั้นกับ Wikipedia ของจริง (2.6 แสนครั้ง vs 2.9 ล้านครั้ง) แต่กราฟการใช้งานมันพุ่งขึ้นอย่างต่อเนื่องตั้งแต่ปลายปีที่ผ่านมา ซึ่งเป็นสัญญาณที่น่ากังวลสุดๆ

ประเด็นคือ Grokipedia ไม่ได้มีความน่าเชื่อถือในระดับมาตรฐานสากล เพราะเนื้อหาเขียนโดย AI (Grok) ล้วนๆ โดยแทบไม่มีมนุษย์ตรวจสอบ แถมมีประวัติวีรกรรมแสบๆ เพียบ ทั้งเนื้อหาที่เต็มไปด้วยอคติ หรือการเขียนอวย Elon Musk แบบสุดลิ่มทิ่มประตู เช่น การลบข้อมูลด้านลบในอดีต หรือใส่ความเห็นส่วนตัวลงไปในข้อเท็จจริง (อ่านข่าวเก่า: Grokipedia สารานุกรม AI จาก Elon Musk เปิดตัวพร้อมเนื้อหาสุดเอียงขวา) การที่ AI เจ้าตลาดไปดึงข้อมูลจากแหล่งที่ "มโน" ขึ้นมาเองแบบนี้ มันเสี่ยงต่อการแพร่กระจายข่าวปลอมหรือข้อมูลบิดเบือนในวงกว้าง

ผู้เชี่ยวชาญจาก Semrush เปรียบเทียบเจ็บๆ ว่า Grokipedia เหมือนพวก "คอสเพลย์ความน่าเชื่อถือ" (Cosplay of Credibility) คือทำหน้าตาให้ดูวิชาการแต่ไส้ในกลวงโบ๋ โดยจากการวิเคราะห์พบว่า Google มักจะใช้เป็นแหล่งอ้างอิงรองๆ คู่กับเว็บอื่น แต่พี่ ChatGPT นี่สิ บางทีดันยกให้เป็นแหล่งข้อมูลหลัก (Primary Source) เฉยเลย ซึ่งทาง OpenAI ก็ออกมาแก้ต่างเพียงสั้นๆ ว่า "เรามีระบบกรองนะ และผู้ใช้ก็กดดูลิงก์ต้นทางเองได้" เหมือนเป็นการโยนภาระให้ผู้ใช้ต้องไปตรวจสอบความจริงกันเอาเอง

เรื่องนี้น่ากลัวตรงที่มันอาจเกิดภาวะ "งูกินหาง" (Circular Sourcing) หรือการฟอกขาวข้อมูล คือ AI สร้างข้อมูลมั่วๆ ขึ้นมา แล้ว AI อีกตัวก็ไปดึงข้อมูลนั้นมาตอบคนใช้งาน วนลูปไปเรื่อยๆ จนความจริงถูกบิดเบือนไปหมด ถ้าบริษัทยักษ์ใหญ่ยังปล่อยให้ AI ของตัวเองไปหยิบข้อมูลจากแหล่งที่ไม่มีมนุษย์ตรวจสอบแบบนี้ อนาคตเราอาจจะต้องมานั่งเถียงกับบอตว่า "ความจริง" คืออะไรกันแน่ และที่สำคัญคือ ใครจะเป็นคนรับผิดชอบเมื่อข้อมูลผิดๆ เหล่านั้นสร้างความเสียหาย?

ความเห็น (0)

เข้าสู่ระบบเพื่อแสดงความเห็น

เข้าสู่ระบบยังไม่มีความเห็น

เป็นคนแรกที่แสดงความเห็นในบทความนี้