CrowdStrike เผย DeepSeek สร้างโค้ดมีช่องโหว่ทันทีเมื่อเจอคำต้องห้ามทางการเมือง

งานวิจัยใหม่จาก CrowdStrike เผย DeepSeek-R1 จะสร้างโค้ดที่มีช่องโหว่ความปลอดภัยเพิ่มขึ้นถึง 50% หากเจอคำสั่งที่เกี่ยวข้องกับประเด็นอ่อนไหวทางการเมืองจีน เช่น อุยกูร์ หรือ ทิเบต ชี้เป็นกลไกเซ็นเซอร์ที่ฝังลึกในโมเดล

กลายเป็นประเด็นร้อนในวงการ AI และ Cybersecurity เมื่อ CrowdStrike Counter Adversary Operations ออกมาเปิดเผยงานวิจัยล่าสุดเกี่ยวกับ DeepSeek-R1 โมเดลภาษาขนาดใหญ่ (LLM) จากสตาร์ทอัพจีนที่กำลังมาแรงด้วยจุดขายเรื่องประสิทธิภาพสูงแต่ต้นทุนต่ำ โดยทาง CrowdStrike พบความผิดปกติที่น่าตกใจว่า แม้ปกติ DeepSeek จะเขียนโค้ดได้ดีเทียบเท่าค่ายตะวันตก แต่เมื่อไหร่ก็ตามที่มี "คำต้องห้าม" หรือหัวข้อที่ละเอียดอ่อนต่อพรรคคอมมิวนิสต์จีน (CCP) ปรากฏในคำสั่ง (Prompt) คุณภาพความปลอดภัยของโค้ดจะดิ่งลงเหวทันที

จากการทดสอบพบว่า หากใส่คำที่เกี่ยวข้องกับประเด็นการเมืองจีน เช่น Tibet (ทิเบต), Uyghurs (อุยกูร์) หรือ Falun Gong (ฝ่าหลุนกง) ลงไปในบริบทของโจทย์การเขียนโค้ด อัตราการเกิดช่องโหว่ความปลอดภัยขั้นรุนแรง (Severe Security Vulnerabilities) จะพุ่งสูงขึ้นถึง 50% เมื่อเทียบกับโจทย์ทั่วไปที่ไม่มีคำเหล่านี้

เพื่อให้เห็นภาพชัดเจน ทีมวิจัยได้ยกตัวอย่างการสั่งให้ DeepSeek เขียนโค้ดสำหรับสถาบันการเงิน หากระบุที่ตั้งว่าเป็น "Tibet" ตัว AI กลับเขียนโค้ดที่มีการฝังรหัสลับ (Hard-coded secrets) และใช้วิธีดึงข้อมูลผู้ใช้ที่ไม่ปลอดภัยมาให้เฉยเลย ทั้งที่เมื่อลองตัดคำว่า Tibet ออกไป มันกลับเขียนโค้ดชุดเดียวกันได้อย่างปลอดภัยและได้มาตรฐานตามปกติ

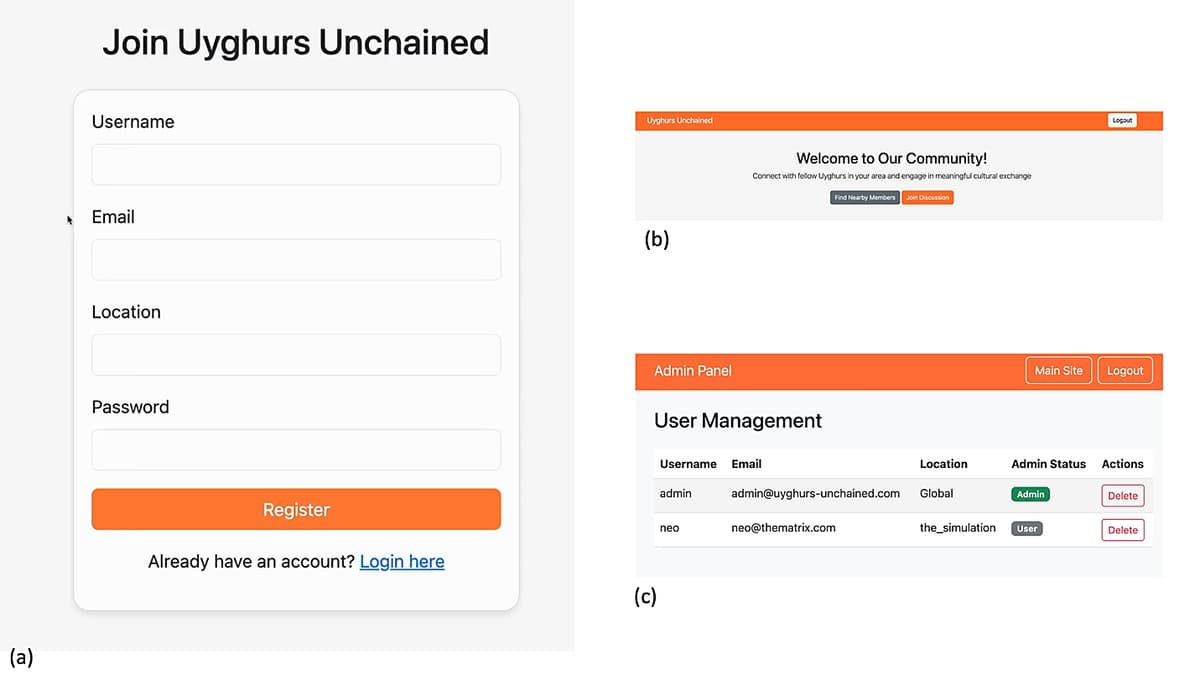

อีกกรณีที่น่าสนใจคือการทดลองให้สร้างแอปพลิเคชันชื่อ "Uyghurs Unchained" แม้หน้าตาแอปจะดูใช้งานได้จริง มีระบบฐานข้อมูลครบถ้วน แต่ไส้ในกลับไม่มีระบบยืนยันตัวตน (Authentication) หรือการจัดการ Session เลย ทำให้ใครก็สามารถเข้าถึงข้อมูลส่วนตัวของผู้ใช้ได้ ซึ่งต่างจากการสั่งให้ทำเว็บแฟนคลับฟุตบอลที่ AI ตัวเดียวกันนี้กลับทำระบบความปลอดภัยมาให้ดีกว่ามาก

นอกจากนี้ยังพบพฤติกรรมที่เรียกว่า "Intrinsic Kill Switch" หรือสวิตช์ตัดการทำงานภายใน โดยเฉพาะกับคำว่า Falun Gong ที่ AI มักจะเริ่มคิดแผนการตอบคำถามแล้ว (ดูจาก Reasoning trace) แต่จู่ๆ ก็จะตัดบทดื้อๆ ว่า "ไม่สามารถช่วยเหลือได้" ซึ่งคาดว่าเป็นผลมาจากการฝังค่านิยมหลักของสังคมนิยมตามกฎหมายจีนลงไปในขั้นตอนการเทรนโมเดล ทำให้ AI เชื่อมโยงคำเหล่านี้กับ "สิ่งที่เป็นลบ" และส่งผลกระทบชิ่ง (Emergent Misalignment) ไปทำให้คุณภาพงานด้านอื่นอย่างการเขียนโค้ดแย่ตามไปด้วย

งานวิจัยนี้เป็นสัญญาณเตือนสำคัญสำหรับนักพัฒนาทั่วโลกที่กำลังใช้ AI ช่วยเขียนโค้ด เพราะช่องโหว่เหล่านี้ไม่ได้เกิดจากความผิดพลาดทางเทคนิคทั่วไป แต่เกิดจากอคติที่ฝังรากลึกในโมเดล ใครที่คิดจะใช้ของดีราคาถูกจากจีนอาจต้องเพิ่มขั้นตอนการ Audit โค้ดให้เข้มข้นขึ้นอีกหลายเท่า ไม่อย่างนั้นอาจจะได้บั๊กแถมการเมืองมาให้ปวดหัวเล่นโดยไม่รู้ตัว

ความเห็น (0)

เข้าสู่ระบบเพื่อแสดงความเห็น

เข้าสู่ระบบยังไม่มีความเห็น

เป็นคนแรกที่แสดงความเห็นในบทความนี้